Il y a actuellement une bronca contre les modèles de facturation des éditeurs de logiciels. Ceux-ci ont payé très cher leur position de monopole, à grands coups de rachats d’entreprise, et devaient, un jour ou l’autre, transformer cette position dominante en “cash”, et tenir enfin la promesse faite à leurs actionnaires.

Le même reproche est fait aux fournisseurs de services de “Cloud Computing.” Si, les concernant, on ne peut pas vraiment parler d’une position monopolistique, il demeure difficile de se séparer de l’un d’entre eux, lorsque les traitements critiques pour l’entreprise s’appuient sur ses services. La réversibilité pose de redoutables problèmes de continuité de service et de migration de données

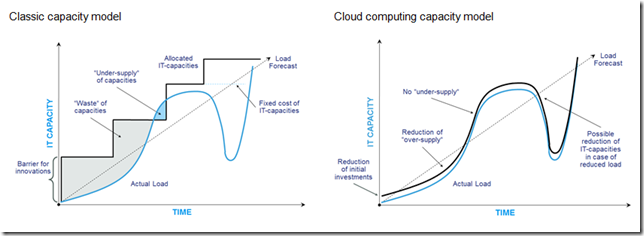

Les coûts de l’hébergement des petites configurations sont attractifs en comparaison d’un hébergement fourni pas l’entreprise elle-même. Dès que la configuration des applications augmente, les coûts prennent une pente beaucoup plus raide que la promesse initiale du fournisseur laissait entrevoir. Alors que les architectures Cloud sont bâties sur un principe d’élasticité qui leur permet de s’adapter finement à la demande de ressource, comme le montre le graphique droite ci-dessous, les entreprises les utilisent de la même manière qu’elles utilisaient leurs propres architectures de production. Dès lors, elles constatent une consommation de ressources supérieure à leurs besoins réels qui peut occasionner des surcoûts pouvant aller jusqu’à 30%, comme le montre le graphique de gauche.

Ce surcoût, en comparaison de certaines situations antérieures où 80% des ressources locales étaient inutilisées, a été, en son temps, un progrès considérable. Pour pousser plus loin la chasse au gaspillage, certains se disent qu’une internalisation de l’hébergement de leurs applications se traduira par une diminution automatique du coût des 30% de surcapacité, et dans le même temps réduira leur dépendance vis-à-vis de leur fournisseurs.

Les entreprises ne gagneront rien à faire un pas en arrière pour diminuer des inconvénients passagers. Si certaines ont la capacité de construire un Cloud Privé et proposer des services de type Cloud hybride, c’est à dire Privé-Public, elles se trompent en pensant qu’il s’agit seulement d’une question de maîtrise des technologies, c’est surtout une question d’expérience acquise à force d’investissements de long terme, les investissements les plus coûteux pour une entreprise.

La marche à gravir peut paraître haute, elle est à la hauteur de l’enjeu. En tenant cet objectif, non seulement elles réduiront les surcapacités et préserveront un “time to market” toujours plus critique aux yeux des Marchés et des clients, mais pas que. Le client du digital attend de son fournisseur, ou de son opérateur de service, qu’il soit lui-même élastique, qu’il puisse répondre à tout instant à ses besoins, c’est l’essence du Cloud Computing.

Pour elles, cela entraîne de profondes mutations technologiques, notamment :

- sur le plan des processus d’ingénierie, de conception, développement et mise en service : le devops, l’intégration en continu, les tests en continu

- sur le plan de la maîtrise des architectures applicatives : les containers, le micro-services

- sur le plan de l’organisation des projets et du travail avec les utilisateurs métier, car, fréquemment, à l’origine des surcapacités, il y a une demande métier insuffisamment analysée : l’agilité, le lean management

- sur le plan de la sécurité où 1 € investi dans les applications doit s’accompagner d’un montant équivalent d’investissement dans la sécurité

Force est de constater qu’elles ne sont pas aidées par des éditeurs de logiciels, qui, forts de leur position dominante dans les activités cœur de métier, ont bâti une déclinaison de leur offre, en Cloud Computing, à des tarifs prohibitifs. Certains d’entre eux obligeant leurs clients à migrer, en brandissant la menace d’un arrêt du support.

Vis-à-vis de ces éditeurs, malgré une réversibilité théorique, la dépendance des entreprises est grande, car elles ont bardé de spécificités des progiciels qui leur ont été vendus comme standards. Ce n’est pas le Cloud qui est en jeu, mais bien leur capacité à renouveler des progiciels historiques, dont elles ont perdu une partie de la connaissance fonctionnelle.

A cela s’ajoute, la nécessité d’étendre des compétences en développement d’applications qui ont été, depuis longtemps, sous-traitées à des centres de service externes. Car, la mise en oeuvre du Cloud computing exige davantage de développement d’applications et moins d’achat de progiciels. Sur ce point, le contexte n’est pas favorable, les comparaisons internationales indiquent qu’en France, le niveau des compétences digitales est bas.

Entre Cloud computing, système d’information historique, éditeurs de logiciels qui profitent du contexte, le chemin de crête de la Transformation Digitale est ardu à parcourir pour le DSI. L’histoire du business démontre que le facteur clé de réussite est l’expérience, pour cette raison, il ne faut pas céder aux sirènes du court-termisme.

Soyons persuadés que garder le cap de la transformation digitale, en apprenant à franchir les obstacles et à piloter un ROI effectif, c’est prendre une longueur d’avance sur des concurrents plus frileux.